Miután Széltoló magához tért elmondta, hogy a Poggyászon több változást is megfigyelt az elmúlt időben. A legszembetűnőbb, hogy a lábait behúzta és újabban kerekeken közlekedik, de belül is történt valami, mert a frissen mosott és vasalt ruhák helyett mindig egy nagy, ezüstös tetejű, azonosíthatatlan rendeltetésű doboz kerül elő belőle, na meg egy vékonyka füzet, amelyben többször szerepel, hogy "8 cores", a nyolc pedig tudvalevőleg Bel-Shamharothhoz köthető.

Terry tudja, hogy vonzódom a nagy, ezüstös tetejű azonosíthatatlan rendeltetésű dobozokhoz, így azonnal engem hívott. A Poggyászt azonnal biztonságos helyre szállítottuk és közelebbről is megvizsgáltuk.

A lábak tényleg eltűntek, helyükön könnyen forduló és gördülő kerekek nőttek, és érdekes címkék kerültek a Poggyász felületére is:

A kerekekből és a súlyból ítélve arra a következtetésre jutottunk, hogy a Poggyász a gyorsabb haladás és a lábai kímélése érdekében váltott haladási módot. Megvizsgáltuk a címkéket is, de sajnos azokon csak számunkra értelmezhetetlen korongvilági szavak voltak, így hát kinyitottuk a Poggyászt:

Az ezüstös tetejű valami, amely a titokzatos "EDDMFSCH-26" névre hallgat gondosan körbe van véve hangszigetelő anyaggal, ebből arra a következtetésre jutunk, hogy zajos lehet, ezért inkább visszacsukjuk a Poggyász tetejét és úgy döntünk, hogy EDDMFSCH-26-ot a hozzá hasonló ezüstös tetejű dobozok szobájában vesszük csak elő.

Mielőtt azonban lecsuknánk a fedelet, kivesszük egy rövid tanulmányozásra a doboz tetején lévő papírokat, amelyekből megtudjuk "Eddie" polgári nevét is:

Ő egy Intel Modular Server!

Most, hogy már beazonosítottuk, bátran beírjuk a nevét a Google-be, amely rögtön el is dob minket egy marketingoldalra, ahol érdekeseket írnak: modern processzorok, dinamikusan kiosztható diszkterület, meg egy benchmark, amely szerint a szerver gyors.

Gyors. Kerekek. Rögtön asszociálunk és le is futtatjuk (vagy gördítjük?) az első sebességtesztet:

Megállapítjuk, hogy a szerver valóban gyors, de sajnos a harmadik klíma mögött rejtőző rendőr lekapcsol minket, így vissza kell térnünk a Poggyász tartalmának vizsgálatához.

Közelről szemrevételezve -de a Poggyászból még nem kivéve- a dobozt, azt láthatjuk, hogy két sorban hét SFF SAS (ill. feltételezhetően SATA) diszk fér bele:

A gépet kiemelve már okosabbak vagyunk:

Az Intel Modular Server egy blade-szerű megoldás, amely áll egy ránézésre passzív házból, illetve modulokból, amelyeket egyesével dughatunk bele.

Elölről és hátulról így néz ki:

Az első részen látható a 14 db. hotswap diszk (illetve azok helye, mi három diszkkel kaptuk), alatta egy ventillátor modul, majd a doboz jobb oldali 2/3-án a 6 darab, ún. Compute Module hely, amelyből esetünkben kettő van feltöltve.

A hátulja bal oldalt két ventillátor modulból, középen egy SCM, SW1 és MM (Storage Controller Module, Switch, Management Module) kártyából áll, amelyekből az SCM és az SW modulokból kettő is lehet a rendszerben.

A doboz jobb oldalán pedig négy tápnak van hely, ebből nálunk kettő volt telepítve, ill. két dummy modul, amelyben csak kisebb ventillátorok vannak.

A doboz önmagában nem sok mindent tartalmaz:

kicsit a p-class HP blade-eket idézi a passzivitásával, bár utóbbi méretben és kapacitásban is nagyobb.

A doboz lényegi tartalma a Poggyász hátán (a fotót az időközben befutott Kétvirág készítette):

A modulokat közelebbről megvizsgálva szembe tűnik, hogy mindegyik hátsón van egy RS-232-es port, illetve a rájuk jellemző egyéb csatlakozók (storage modulon külső SAS csatlakozó, a switch modulon RJ-45-ös Ethernet portok, a management modulon szintén egy RJ-45-ös Ethernet):

A tápegységet megnézve azt láthatjuk, hogy 1050W-os, kínai (American components, Russian components: all made in Taiwan) és Delta. Ugyanaz, mint az x86-os HP szerverekben.

A dobozon találunk egy figyelmeztető jelzést is:

amely sajnos meghiúsítja ördögi tervünket (munkahelyi üdítő- és csokoládéautomatára gyűjtünk).

A Compute Module, azaz a "blade szerver" így néz ki:

Két, passzívan hűtött 5400-as szériájú négy magos Xeon processzor (előtte és közvetlenül mögötte sincs ventillátor, így egy műanyag légcsatornával próbálják "csőbe húzni" a levegőt) van a szerverünkön. A kártyán rend van, 8 darab memóriaslot (gépünkben 2 GB van) található rajta, amellyel 32 GB-ig biztosan bővíteni tudjuk a szervereket, hátul egy rendszer és egy tápcsatlakozó, ATI ES1000 videochip, és a jobb hátsó sarokban a mezzanine kártya bővítőhelye.

Érdekes a modul elején lévő hely, úgy tűnik az Intel meghagyta a lehetőségét annak, hogy a későbbiekben a modulra is tehessünk legfeljebb két helyi diszket (esetleg mást, pld. bővítőkártyákat), ha a közös megoldás nem válna be.

Fan modul és Ethernet switch:

Storage controller:

Jól látható a külső SAS csatlakozó, amelyre a beépített expanderen keresztül köthetünk külső storage-ot (ez enyhíti kicsit a SAN opció hiányát). A kontroller maga LSI chipes, 512MB cache-t tartalmaz (amely értelemszerűen megoszlik a szerver modulok között), illetve a miénkben volt egy akksi is, amely feltételezhetően segít a cache-nek nem felejteni, illetve az írást ilyen módon gyorsítani.

A menedzsment modul egy Realtek chippel kezdődik:

és egy lighttpd-t:

telnet 172.16.133.181 80

Trying 172.16.133.181...

Connected to 172.16.133.181.

Escape character is '^]'.

HEAD / HTTP/1.0

HTTP/1.0 302 Found

Connection: close

X-Powered-By: PHP/5.2.2

Set-Cookie: PHPSESSID=hg5q1jiu3i07l3ummjes5evs84; path=/

Expires: Thu, 19 Nov 1981 08:52:00 GMT

Cache-Control: no-store, no-cache, must-revalidate, post-check=0, pre-check=0

Pragma: no-cache

Location: https:///

Content-type: text/html

Content-Length: 0

Date: Wed, 13 Feb 2008 11:34:13 GMT

Server: lighttpd/1.4.11

futtató ilyen OS-sel végződik:

Starting Nmap 4.52 ( http://insecure.org ) at 2008-03-16 11:01 CET

Interesting ports on 172.16.133.181:

Not shown: 1702 closed ports

PORT STATE SERVICE

80/tcp open http

111/tcp open rpcbind

199/tcp open smux

443/tcp open https

623/tcp open unknown

624/tcp open unknown

625/tcp open apple-xsrvr-admin

2201/tcp open ats

6346/tcp filtered gnutella

8000/tcp filtered http-alt

8080/tcp open http-proxy

10000/tcp open snet-sensor-mgmt

MAC Address: 00:15:17:34:20:13 (Intel Corporate)

No exact OS matches for host (If you know what OS is running on it, see http://insecure.org/nmap/submit/ ).

TCP/IP fingerprint:

OS:SCAN(V=4.52%D=3/16%OT=80%CT=1%CU=32827%PV=Y%DS=1%G=Y%M=001517%TM=47DCF23

OS:C%P=amd64-portbld-freebsd7.0)SEQ(SP=BB%GCD=1%ISR=C5%TI=Z%TS=7)SEQ(SP=BC%

OS:GCD=1%ISR=C5%TI=Z%TS=7)OPS(O1=M5B4ST11NW2%O2=M5B4ST11NW2%O3=M5B4NNT11NW2

OS:%O4=M5B4ST11NW2%O5=M5B4ST11NW2%O6=M5B4ST11)WIN(W1=16A0%W2=16A0%W3=16A0%W

OS:4=16A0%W5=16A0%W6=16A0)ECN(R=Y%DF=Y%T=40%W=16D0%O=M5B4NNSNW2%CC=N%Q=)T1(

OS:R=Y%DF=Y%T=40%S=O%A=S+%F=AS%RD=0%Q=)T2(R=N)T3(R=Y%DF=Y%T=40%W=16A0%S=O%A

OS:=S+%F=AS%O=M5B4ST11NW2%RD=0%Q=)T4(R=Y%DF=Y%T=40%W=0%S=A%A=Z%F=R%O=%RD=0%

OS:Q=)T4(R=Y%DF=Y%T=40%W=0%S=O%A=Z%F=R%O=%RD=0%Q=)T5(R=Y%DF=Y%T=40%W=0%S=Z%

OS:A=S+%F=AR%O=%RD=0%Q=)T5(R=Y%DF=Y%T=40%W=0%S=Z%A=O%F=AR%O=%RD=0%Q=)T6(R=Y

OS:%DF=Y%T=40%W=0%S=A%A=Z%F=R%O=%RD=0%Q=)T6(R=Y%DF=Y%T=40%W=0%S=O%A=Z%F=R%O

OS:=%RD=0%Q=)T7(R=Y%DF=Y%T=40%W=0%S=Z%A=S+%F=AR%O=%RD=0%Q=)T7(R=Y%DF=Y%T=40

OS:%W=0%S=Z%A=O%F=AR%O=%RD=0%Q=)U1(R=Y%DF=N%T=40%TOS=0%IPL=164%UN=0%RIPL=G%

OS:RID=G%RIPCK=G%RUCK=G%RUL=G%RUD=G)IE(R=Y%DFI=N%T=40%TOSI=Z%CD=S%SI=S%DLI=

OS:S)

Uptime: 1.847 days (since Fri Mar 14 14:51:01 2008)

Network Distance: 1 hop

A switch modul közelről szintén egy egy-két chipes integrált megoldás, 10 porttal:

Míg végignéztük a részegységeket a dolgos kezek berakták a rackbe a dobozt, a versenyszellem jegyében egy HP p-class (régebbi) blade enclosure-re:

Miután ez is megvolt, úgy gondoltuk, hogy bekapcsoljuk a gépezetet, amely még ebben a zajos környezetben is olyan hangos volt, hogy egy közeli Linux meggondolta magát és a biztonság kedvéért elpánikolt:

Mi azonban nem ijedtünk meg, rádugtunk a menedzsment konzolra egy notebookot és figyeltük, hogy mi történik. Semmi. Reménykedtünk kicsit, hogy legalább valami DHCP-s, vagy bármilyen más hálózati próbálkozás lesz, de hát ha nem, hát nem, szégyenszemre elővettük a manualt:

Azt mondja, hogy a Mozilla Firefox nevű alkalmazással kell elérni a konzolt a 192.268.150.150-es címen. Hollywoodi jelenetek jutnak hirtelen az eszünkbe, de kicsit arréb csúszik a szemünk a lapon és máris olvashatjuk a helyes megoldást:

A default usernév, jelszó: admin/admin

Mielőtt azonban belépnénk, nézzük meg kicsit, hogy hogyan is épül fel a gép.

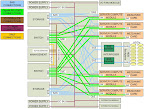

Az Intel Technical Product Specification nevű PDF-ből kiollózott architekturális (huzalozási) diagram:

Ezek szerint minden Compute Module egy-egy SAS kapcsolattal rendelkezik a két storage controller felé, amely így képessé válik a redundancia biztosítására. A weblap szerint ezt a redundanciát a rendszer még nem támogatja, implementálása 2008. első negyedévére (az most van) várható. A storage controllereken nem közvetlenül lógnak a diszkek, hanem összesen két SAS expanderen keresztül érik el a SAS backplane-t. Ahhoz, hogy a rendszer a Compute Module-tól a diszkig redundáns legyen, értelemszerűen dupla útvonallal kell, hogy rendelkezzen. Ennek érdekében a rendszerrel szállított Seagate diszkek is duplaportosak, azaz bármelyik komponens (útvonal, SCM, SAS expander) kiesését képes a diszk elvesztése nélkül elviselni a rendszer.

A diszkek "A" és "B" portja egy-egy összerendelésben van a storage controllerrel és az expanderrel, azaz az SCM1 csakis az egyes expanderen keresztül fogja elérni a diszkek "A" SAS portját, míg az SCM2 a kettes expanderen a diszkek "B" portját.

Az SCM1-expander2 és SCM2-expander1 SAS kapcsolat a két SCM cache szinkronizációjára van fenntartva (kérdés, hogy ez fizikailag egy kapcsolatot jelent-e, mert ezesetben szűk keresztmetszetet jelenthet).

A switch modul tíz külső Gigabit Ethernet porttal rendelkezik, illetve belül minden gép felé két port (összesen tehát 12) látszik. Ezen felül az opcionális második switch felé egy 10 gigabites belső kapcsolat van, illetve a doksi szerint az SCM felé is ki van építve egy 10GE link. Ennek szerepe egyelőre nem tisztázott, vélhetőleg a későbbiekben iSCSI-szerű funkcionalitást nyújthat majd (bár a belső diszkek esetében ennek nem sok értelmét látom).

Most, hogy már tudjuk mivel állunk szemben, lépjünk be a menedzsment felületre (amelynek még fent a gépteremben egy keresztkábellel átállítottuk a hálózati interfészét DHCP-sre).

A bejelentkező képernyő átlátszó login-ablaka már sejtet némi modernitást, amit méginkább megerősít a belépés után látható dashboard:

A dashboardon a leglényegesebb információkat láthatjuk: van-e valamilyen teendő a szerverünkkel (nincs), az "egészsége" (kiváló), az áramfelvétel a tápegységek számának tükrében (egyértelmű jelzéseket kapunk: ha a zöld sávban vagyunk, a rendszer egy tápegység kiesését gond nélkül elviseli, ha a sárgában, egy újabb táp elvesztése már meghatározhatatlan következményekkel jár, ha pedig a pirosban áll a mutató, a rendszer túlterhelt, ne csodálkozzunk azon, ha kiszámíthatatlanná és megbízhatatlanná válik a szerver működése).

A dashboardon látható még egy hőmérsékleti kijelző (környezeti, szerver CPU-k és diszkek), illetve egy ízelítő a legutolsó kritikusnak ítélt eseményekből.

Továbblépve megtekinthetjük szerverünk elejét és hátulját is, és joggal bízhatunk abban, hogy ezek az ábrák a valóságot fogják tükrözni, azaz a megjelenített eszközök ott vannak, ahol azt a lapon látjuk (vagy éppen nincsenek):

Mint az látható, a szervereknél megszokott módon a doboz és minden modul tele van szórva érzékelőkkel (amelyekre riasztási küszöbök is állíthatók). A kívánt információt általában többféleképpen is megszerezhetjük: a gépekhez hozzárendelt diszkterületeket például megnézhetjük a szerver információs ablakaiban és a storage menedzsment fülön is.

Itt érdemes szót ejteni arról, hogy mit is jelent az, hogy a storage controller virtualizálja a diszkeket. A "hagyományos" RAID kontrollerekkel, illetve blade (pld. HP blade-eknél) megoldásokkal szemben itt a szervereknek (Compute Module) csak SAS kapcsolatuk van a storage controller felé, azaz diszket közvetlenül nem látnak. A storage controller feladata, hogy minden gép számára tudjunk tárhelyet biztosítani, ezt azonban nem úgy teszi, hogy a legkisebb egységként a diszket ajánlja fel (azaz pld. az első szervernek az első két diszket odaadja RAID 1-ben), hanem a diszkek fölé storage poolok, azok fölé pedig virtuális diszkek (volume-ok) szervezhetők.

Ez azt jelenti, hogy a mi három diszkünk esetében ezeket egy poolba téve "csíkokat", volume-okat, virtuális diszkeket alakíthatunk ki, amelyek aztán a választott redundancia (RAID) szint szerint fognak rendelkezésre állni.

Három diszkkel RAID 0-át (striping), 1-et (mirroring), 5-öt (striping+parity block), illetve 1E-t (stripe+mirroring) választhatunk, de megfelelő méretű pool (elég diszk) esetében használhatunk RAID 6-ot (dupla paritás), RAID 10-et, 50-et, vagy 60-at is. Azaz szinte minden értelmes kialakítást.

A virtuális diszkek kialakítása gyerekjáték:

Mint látható, a virtuális diszkeket szerverekhez rendelhetjük, illetve beállíthatjuk, hogy azok milyen LUN-nal lássák azt (a boot diszknek érdemes a 0-ásat adni).

Sajnos az Intel kihagyott egy nagyszerű lehetőséget, amely például a HP blade megoldása fölé emelte volna ezt a rendszert: a virtuális diszkek csak egy szerverhez köthetők, egy diszket nem érhet el több szerver.

Az architektúra egyértelműen lehetővé teszi ezt, segítségével pedig viszonylag olcsón, külső SAN (vagy egyéb, ekvivalens) megoldás nélkül lehetne shared diszkes clustereket (pld. mini Oracle RAC, vagy HA clusterek osztott adatterülettel) építeni egy kompakt megoldásban.

Ha valakinek esetleg nehezére esne követnie, hogy melyik diszk milyen virtuális diszkeket tárol, illetve azokat mely szerverek használják, segítség lehet a storage layout, amely egy bonyolultabb megosztás esetében igen hasznos lehet:

A háttértár mellett nagyon fontos a hálózat. A mi eszközünkben egy darab switch kapott helyet (a rajz szerint a második switch által biztosított két plusz port gépenként csak egy külön beszerzendő mezzanine kártyával vehető igénybe), amely a világ felé tíz GE porttal, befelé pedig 12 (gépenként kettő) GE-vel kapcsolódik.

Szintén a clusteres képességek javítása kapcsán úgy gondolom, hogy néhány területen értékelték volna a GE helyett a gyorsabb interconnect megoldásokat is (például InfiniBand), de ha már ez nem fért bele, a két GE port ellensúlyozásaként hasznos lett volna legalább 2,5 gigabites Ethernetet tenni belülre, mellé pedig ehhez passzoló switchet. Apró bibi persze, hogy ilyet jelenleg csak a Broadcom gyárt, itt meg ugye Intel megoldásról beszélünk. (a 10 GE valószínűleg költség oldalról volt ellenjavallt, illetve könnyen lehet, hogy a szegmens, amelyet megcéloztak vele, nem is igényli ezeket a sebességeket)

Szóval a switch. A switchet kétféleképpen menedzselhetjük: egy egyszerű felületen, amely integrálva van a fent bemutatottal, illetve egy fejlettebb (még mindig webes) GUI-n, ahol sokkal több beállítás elvégzésére van mód.

Az egyszerű beállító-felület a port státuszát (enabled/disabled), a VLAN-t, a sebességet (10-100-1000, FDX, HDX) és a STP alapvető befolyásolását teszi lehetővé:

A részletesebb, több beállítást lehetővé tévő felület egy új böngészőablakban (másik webszerveren, porton) jön be:

amely rögtön érdekes megoldásra hívja fel a figyelmet: a switch IP címe a lap szerint 1.1.1.71, így a külső menedzsment modulon minden bizonnyal egy HTTP proxy fut, amely továbbítja belülre a kéréseket.

A switch képességeire jól lehet következtetni a bal oldali lenyíló menüben szereplő pontokból:

Az eszköz tudása egy átlagos layer 2 switché: port tükrözés, kábelmérés (távolság, érvizsgálat, skew), storm control (broadcat, ismeretlen unicast, multicast), port security, ACL-ek (MAC és IP alapon), interface trunking (LAG, LACP), STP (RSTP, PVSTP), VLAN (a GARP és GVRP-ből ítélve nem éppen Cisco switch van belül), VLAN grouping (MAC cím, IP subnet, és protokoll (IP/IPX/ARP) alapján), QoS és az általános statisztikák.

A menedzsment felületen természetesen több user is létrehozható, ezek külön szabályozhatók RW/RO alapon az egyes nagyobb egységekre nézve (chassis, storage, switch admin, illetve a hat szerver egyesével). A felhasználókhoz riasztási szintek köthetők, amelyek egyesével beállíthatók minden típusra:

A gépek távmenedzsmentjét távoli soros porttal, illetve KVM (Keyboard, Video, Mouse) átvételével lehet intézni, utóbbihoz egy virtuális CD is társul, amely a gépünkön lévő CD/DVD drive-ot közvetlenül, vagy a gépünk diszkjén lévő image-ből (ISO) tud dolgozni. A remote KVM alkalmazás Java WS-os, kétféle mód (high, low resolution) közül választhatunk, az erőforrásaink (pld sávszélesség) és igényünk függvényében.

Az alkalmazás képminősége és -frissítése jó (viszonyítási alap a HP ILO-ja, amely néha egyenesen katasztrofális), a virtuális CD viszont nekem nagyon lassú volt (helyi gigabites hálózat).

A KVM program menüjéből vezérelhetjük azokat a gombokat, amelyeket az nem tud átvinni közvetlenül és itt kapcsolhatjuk be, vagy ki a távoli CD/DVD-t is:

A menedzsment felületről készült videók:

http://ftp.fsn.hu/contrib/bra/intelmodular-mgmc.avi

http://ftp.fsn.hu/contrib/bra/intelmodular-switch.avi

http://ftp.fsn.hu/contrib/bra/intelmodular-fbsdinstall.wmv

Miután kiveséztük szinte az egész gépet, ejtsünk pár szót a szerverekről is. A mi dobozunk két Compute Module-lal érkezett, amelyekben 2 db. L5410-es (2,33 GHz-es, 1333 MHz-es FSB-s, 12MB L2 cache-es) quad core Xeon processzor és 2 GB RAM volt.

A processzorok tekintetében az L5410 -az E5410-es alacsony feszültségű (LV) párja- az 5400-as széria ("Harpertown") majdnem legkisebb CPU-ja, alatta már csak az 5405 van (2G/1333MHz), felette pedig még jópár változat, a jelenleg legnagyobb X5482-vel bezárólag (3,2G/1600MHz).

Ez azonban ne tévesszen meg bennünket, hiszen az "új" Xeonokból már az 5300-as széria is nagyon gyors volt, amelyre még egy lapáttal rátett az Intel az 5400-assal.

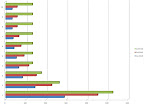

Bár semmiképpen nem mondanám kimerítő CPU benchmarknak, azért lefuttattam a sysbench CPU tesztjét három különböző gépen. Az egyik a cikk tárgya, azaz két darab Intel L5410-es (2,33 GHz) quad core xeonos gép, a másik egy HP BL460c, ugyancsak két darab quad core Xeonnal, de az előző szériából (E5345, 2,33GHz), a harmadik pedig egy még korábbi verzió, az 5130, amely csak két magos és 2 GHz-en ketyeg.

A következő parancs:

for i in `jot 32`; do sysbench --num-threads=$i --test=cpu --cpu-max-prime=100000 run | grep 'total time:' | egrep -o '[0-9]+\.[0-9]+'; done

eredménye:

Az x tengelyen a futásidő látható másodpercben, míg az y-on a threadek száma a ciklusban.

Az Intel eléggé belehúzott az elmúlt évben, ráadásul meglehetősen aggresszív árpolitikát folytat (az 5400-as CPU-k olcsóbbak, mint az elődeik).

A gépek BIOS-a átlagosnak mondható:

A memória a modulok számától függően teljes egészében felhasználható (no RAS), tükrözhető (a memóriamodulok felének kiesését tolerálja a rendszer, értelemszerűen a kapacitás felezésével), illetve tartalékolható (memória RAID 5, ahol egy modult elveszthetünk a működés befolyásolása nélkül). Kíváncsi vagyok, hogy ha az Intel is áthelyezi a memóriavezérlőt a processzorba, eltűnnek-e ezek a funkciók a low-end, midrange x86-os szerverekből.

A gépben egy LSI 1064E SAS vezérlő biztosítja a kapcsolatot a storage controller, és így a diszkek felé, a hálózati elérést pedig Intel PRO/1000 EB NIC-ek adják.

Vélemény:

Az Intel Modular Servert két dologgal tudnám összehasonlítani. Az egyik hat darab 1U-s rackmount szerver (a modular server doboza is 6U-s és hat Compute Module fér bele), a másik pedig egy hasonló méretű blade megoldás (ezekből leginkább a HP-t ismerem).

A rackmount szerverekkel szembeni előnye világos: kompaktabb, egységes környezet, dinamikusan kiosztható diszkterület, integrált switch és sok mindenre kiterjedő monitoring, riasztási lehetőség, távmenedzsment.

Árban valószínűleg az 1U-s rackmount szerverek nagy többsége fölött van, azonban ha azok teljes költségéhez hozzászámítjuk a valószínűleg kisebb fogyasztás, a switch és az ilyen szintű távmenedzsment lehetőségét is (azaz nem a legolcsóbbat vesszük), könnyen lehet, hogy azonos, vagy éppen magasabb árat kapunk.

A blade megoldással szemben jelenleg hátrányként róható fel a választék hiánya, amely mind a szerver-modulok, mind a beléjük helyezhető kiegészítő kártyák (mezzanine és backplane modulok) tekintetében fennáll.

A rendszer felépítéséből adódik a kérdés: mennyire jövőbiztos az architektúra, milyen további fejlesztések várhatók?

Bár elvi lehetősége van annak, hogy akár mezzanine kártya nélkül Fibre Channel, vagy InfiniBand képessé váljon a szerver (például egy olyan kombinált storage controllerrel, amely a belső SAS kapcsolatokon keresztül valósítja meg az elérést, kifelé pedig FC, vagy IB csatolóval rendelkezik), azonban elképzelhető, hogy abban a szegmensben, amelyet az Intel megcélzott a Modular Serverrel nincs is igény az ilyen -jellemzően magasabb árszínvonalat képviselő- megoldásokra.

A Modular Servert egy belépő szintű blade megoldásnak érzem, amely némileg kisebb bővíthetőséget ad, mint a "nagy" blade megoldások, azonban -feltételezhetően- alacsonyabb áron teszi ezt, hasonló szolgáltatások mellett. Annak, aki több, két processzoros x86-os szerver felett "uralkodik", esetleg most még csak kevesebbel indulna, de a későbbiekben bővülne és együtt tud élni a fent említett hiányosságokkal, mindenképpen hasznos megoldás lehet.

A tesztgépet az ASBIS Magyarország biztosította, köszönet érte.

A tesztről készült összes kép itt tekinthető meg.

ui: miután kivettük a Poggyászból a Modular Servert, visszanőttek a lábai, megrázta magát -tiszta ruha illatát árasztva magából-, majd elsietett (ezt egy tűzálló géptermi ajtónk bánta, amely önhibáján kívül éppen zárt állapotban tartózkodott, amikor meg kellett tapasztalnia a tudákos körtefa földöntúli erejét) Széltolóhoz, aki Ankh-Morporkból üzeni, hogy épp jókor érkezett a láda, mert már nagyon fogytán volt a tiszta alsónak.

- A hozzászóláshoz be kell jelentkezni

- 5715 megtekintés

Hozzászólások

Érdekes írás, köszönjük szépen.

btw az Intel mióta gyárt komplett szervereket??

---

Ketchup elementál megidézése a sajt síkra

- A hozzászóláshoz be kell jelentkezni

Emlékeim szerint sosem gyártott. Komponenseket adott (ház, alaplap, processzor, stb), amelyekbe aztán azt vettél, amit akartál, de kompletten, úgy, ahogy egy HP, vagy IBM ad gépet, nem árulta őket.

- A hozzászóláshoz be kell jelentkezni

Jellemző a magyar szakemberekre, hogy nem követik a használati utasítást? :)

"Azt mondja, hogy a Mozilla Firefox nevű alkalmazással kell elérni a konzolt a 192.268.150.150-es címen."

"...handing C++ to the average programmer seems roughly comparable to handing a loaded .45 to a chimpanzee."

-- Ted Ts'o

- A hozzászóláshoz be kell jelentkezni

Hehe, jó a stílus. :)

Mivel nem értek hozzá, csak egy olyat kérdezek, hogy az Intel miért ATI grafikus chipet rakott bele? Egyrészt az AMD versenytárs, másrészt az Intel gyárt saját chipet. Tudom, hogy kb. tökmindegy, mit raknak bele, mert egy szerveren tényleg mindegy, de legalább elvből lehetne Intel rajta. :)

- A hozzászóláshoz be kell jelentkezni

+ miert realtek-et?

- A hozzászóláshoz be kell jelentkezni

Sok magyarázata lehet, a "más tervezte"-től az "olcsóbb volt"-ig. :)

- A hozzászóláshoz be kell jelentkezni

Gratulálok ! Nekem nagyon elnyerte a tetszésem a cikk. Jól meg van fogalmazva :).

__________________________________________

Hungarian Unix Portal » Ubuntu » Linux Blog

- A hozzászóláshoz be kell jelentkezni

Éljen Pratchett, éljen Széltoló!

A nyolcmagú kevésbé érdekel...

KisKresz

- A hozzászóláshoz be kell jelentkezni

Kubuntu + compiz megy rajta? :P

- A hozzászóláshoz be kell jelentkezni

KVM-mel? Egészen biztosan. :)

- A hozzászóláshoz be kell jelentkezni

Hmm, a sulikban lévő "Fekete doboz"-okhoz hasonló a kinézete, csak épp a tartalma kicsit jobb. Esetleg le lehetne cserélni :P

- A hozzászóláshoz be kell jelentkezni

Ejj, ejj, hogy lehet 268 egy IP-cimben? IPv8? Maskepp jo cikk, nagyon butanak erzem magam utana. (az is vagyok)

---

Hey! Where'd my terminal go?

- A hozzászóláshoz be kell jelentkezni

megvaltoztatta hogy ne tudd elerni browseredbol

- A hozzászóláshoz be kell jelentkezni

_Annyira_ azert nem vagyok buta ;)

---

Hey! Where'd my terminal go?

- A hozzászóláshoz be kell jelentkezni

Nem vagy buta, ha nem ismered Pratchettet. Inkább csak kimaradt pár könyv, amit érdemes lesz elolvasnod (már persze ha fogékony vagy rá :).

- A hozzászóláshoz be kell jelentkezni

Ajánlom magamat. :)

- A hozzászóláshoz be kell jelentkezni

Jo cikk, de egy kep kimaradt:

http://upload.wikimedia.org/wikipedia/en/1/1b/Anthill_inside.png

Anthill inside

:)

----

honlapkészítés

- A hozzászóláshoz be kell jelentkezni

"Megállapítjuk, hogy a szerver valóban gyors"

Ekkor az elgurult gyógyszert üldöztétek? :)

- A hozzászóláshoz be kell jelentkezni

Kis plusz info errol:

"Sajnos az Intel kihagyott egy nagyszerű lehetőséget, amely például a HP blade megoldása fölé emelte volna ezt a rendszert: a virtuális diszkek csak egy szerverhez köthetők, egy diszket nem érhet el több szerver."

Nos, az intel gondolkodik ugy tunik. Ugyanez a teszt szerver pihen nalunk a szerverszobaban. Hianyzott nagyon a shared storage funckio. Megoldottak. Firmware update utan benne van az Intel Sared LUN. Persze nem ingyen, venni kell hozza szoftverkulcsot ami aktvalja. A BIOS Release P2.6, Build 14717 -tol mar benne van ez a feature. BIOS kiadasank idopontja : November 20, 2008, friss cucc.

udv.

secret

- A hozzászóláshoz be kell jelentkezni